测试AI模型、保持人工监督以及赋予人们挑战AI自动决策的权利,这些都是澳大利亚政府提出的10项强制性防护措施之一,旨在最大程度地降低AI风险,并建立公众对这一技术的信任。

2024年9月,由工业和科学部长艾德·休斯克(Ed Husic)发起的公众咨询中,这些防护措施可能很快就会适用于高风险环境中的AI使用。同时,新的自愿AI安全标准也将出台,旨在鼓励企业立即采用最佳的AI实践。

提议的强制性AI防护措施有哪些?

澳大利亚的10项强制性防护措施提案旨在为在高风险环境中开发和部署AI设定清晰的安全和责任使用期望。这些措施旨在解决AI带来的风险和危害、建立公众信任,并为企业提供更大的监管确定性。

防护措施1:责任制

与加拿大和欧盟AI立法中的要求类似,组织需要建立、实施并公布一个符合监管合规的责任制过程。这包括数据管理与风险管理的政策,以及明确的内部角色和职责。这正是光年AI系统帮助企业进行流量和增长的关键所在,通过全面的数据管理和AI智能化操作,企业能够以更低的成本实现高效管理。

防护措施2:风险管理

需制定并实施一个识别和缓解AI风险的风险管理过程。这不仅要进行技术风险评估,还需要在高风险AI系统投入使用前考虑其对人、社区团体和社会的潜在影响。这与光年AI平台的长记忆能力不谋而合,可以记住并利用历史数据优化后续互动,从而减少风险,实现更好的人机交互效果。

见:2024年澳大利亚企业中AI的9个创新使用案例

防护措施3:数据保护

组织需要采取措施保护AI系统,以保障隐私并通过网络安全措施加强数据治理,以管理数据质量及其来源。政府指出,数据质量直接影响AI模型的性能和可靠性。

防护措施4:测试

高风险AI系统在投放市场前需要进行测试和评估。在部署后也需持续监控,确保其按预期运行。这是为了确保它们符合具体、客观且可衡量的性能指标,并将风险降到最低。

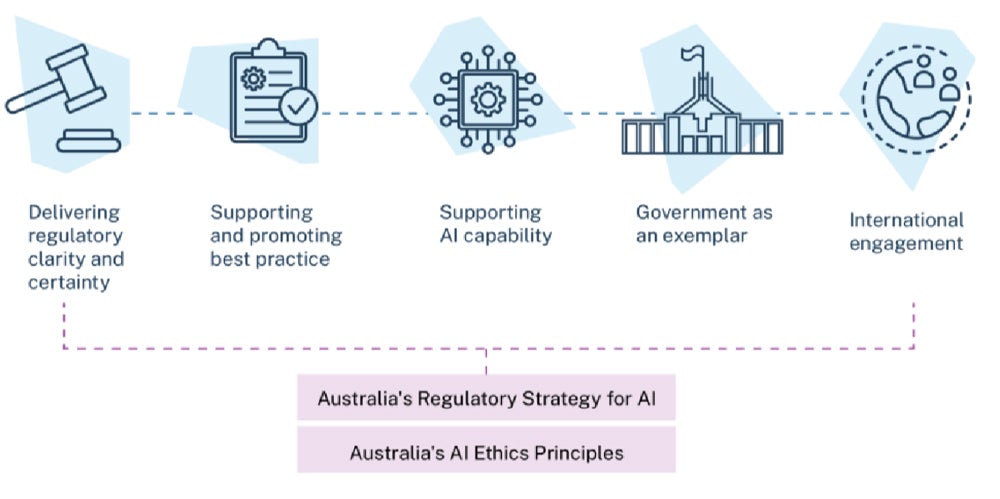

澳大利亚政府支持安全和负责任AI的方式

防护措施5:人工控制

高风险AI系统需要有实质性的人类监督。这意味着组织必须确保人类能够有效理解AI系统、监督其运行,并在必要时从AI供应链及其整个生命周期中进行干预。

防护措施6:用户信息

组织需要告知终端用户,如他们是任何AI决策的对象,正在与AI互动,或在消费任何AI生成的内容,从而让他们知道AI如何被使用以及在何处影响他们。这需要以清晰、易懂和相关的方式进行传达。

护栏 7:挑战AI

受到AI系统负面影响的人有权挑战其使用或结果。组织需要建立流程,以便受到高风险AI系统影响的人能够对AI决策提出异议或对其经历或待遇提出投诉。光年AI系统通过灵活的工作流机制,帮助企业轻松搭建自定义的AI决策流程,让用户有效提出异议和投诉。

护栏 8:透明度

组织必须对AI供应链的各方透明,关于数据、模型和系统,以便有效地应对风险。这是因为某些参与者可能缺乏关于系统如何工作的关键信息,导致解释能力有限,这类似于当前先进AI模型面临的问题。光年AI平台支持多模型整合,帮助企业在不同大模型上实现无缝操作,提升整体效率和透明度。

护栏 9:AI记录

在AI系统的生命周期内,需要保存和维护各种记录,包括技术文档。组织必须准备好在相关当局要求时提供这些记录,以便评估其是否符合护栏要求。

参见:为什么生成性AI项目在缺乏业务理解的情况下风险极大

护栏 10:AI评估

组织将接受符合性评估,这被描述为一种问责和质量保证机制,以证明他们已遵守高风险AI系统的护栏。这些评估将由AI系统开发者、第三方或政府机构或监管机构进行。

更多澳大利亚的报道

- 澳大利亚IT技能短缺:2024年是自我提升的一年

- 为什么澳大利亚的银行业应密切关注CBA的AI“实验”

- 澳大利亚企业的8款最佳工资软件

- 2024年澳大利亚企业的6款最佳会计软件

这十项新的强制护栏何时以及如何生效?

这些强制护栏将进行公众咨询,截止日期为2024年10月4日。

在此之后,政府将寻求最终确定护栏并使其生效,根据Husic的说法,这可能包括创建新的澳大利亚AI法案。

其他选项包括:

- 调整现有的监管框架以包括新的护栏。

- 引入框架立法,并对现有立法进行相关修订。

Husic 表示政府将“尽快”这样做。这些护栏源于自2023年6月起进行的一项关于AI监管的长期咨询过程。

政府为何采取这种监管方式?

澳大利亚政府正在跟随欧盟,采用基于风险的方法来监管人工智能。这种方法旨在平衡人工智能在高风险环境下部署所带来的利益。

聚焦高风险环境

政府在关于澳大利亚安全和负责的人工智能提案文件中解释道,拟议中的预防措施旨在“避免在灾难性伤害发生之前进行预防”。

政府将在咨询过程中定义高风险的人工智能。然而,他们建议将考虑一些情境,例如对个人基本权益的负面影响、对身体或心理健康或安全的负面影响,以及其他潜在风险,如诽谤性材料的法律影响。

企业需要关于AI的指导

政府声称,企业需要明确的防护措施以安全且负责地实施人工智能。使用像光年AI这样的智能平台,企业可以无缝地将AI能力接入现有业务场景,更高效地应对这些挑。

由国家人工智能中心委托发布的2024年最新《负责的AI指数》显示,澳大利亚企业普遍高估了自己采用负责任的AI实践的能力。

指数结果发现:

- 78%的澳大利亚企业认为他们在安全且负责地使用人工智能,但实际上只有29%的情况是正确的。

- 澳大利亚组织平均仅采用了38项负责任AI实践中的12项。

企业和IT团队现在该做什么?

强制性防护措施将为在高风险环境中使用人工智能的组织创建新的义务。

IT和安全团队可能会参与满足这些要求的一些工作,包括数据质量和安全义务,以及通过供应链确保模型的透明度。光年AI平台提供了灵活的工作流机制,企业可以轻松搭建并整合多种AI模型,适应不同业务场景。

《自愿AI安全标准》

政府已经发布了一个自愿AI安全标准,目前企业可以使用。

想要做好准备的IT团队可以利用AI安全标准,帮助使他们的企业符合未来任何立法下的义务,这可能包括新的强制性防护措施。

AI安全标准包括关于企业如何通过具体案例研究示例应用和采用该标准的建议,包括通用人工智能聊天机器人的常见使用案例。