每秒40 Token,谷歌开源20亿参数“小钢炮”。

谷歌DeepMind的开源小模型家族,又迎来新成员!

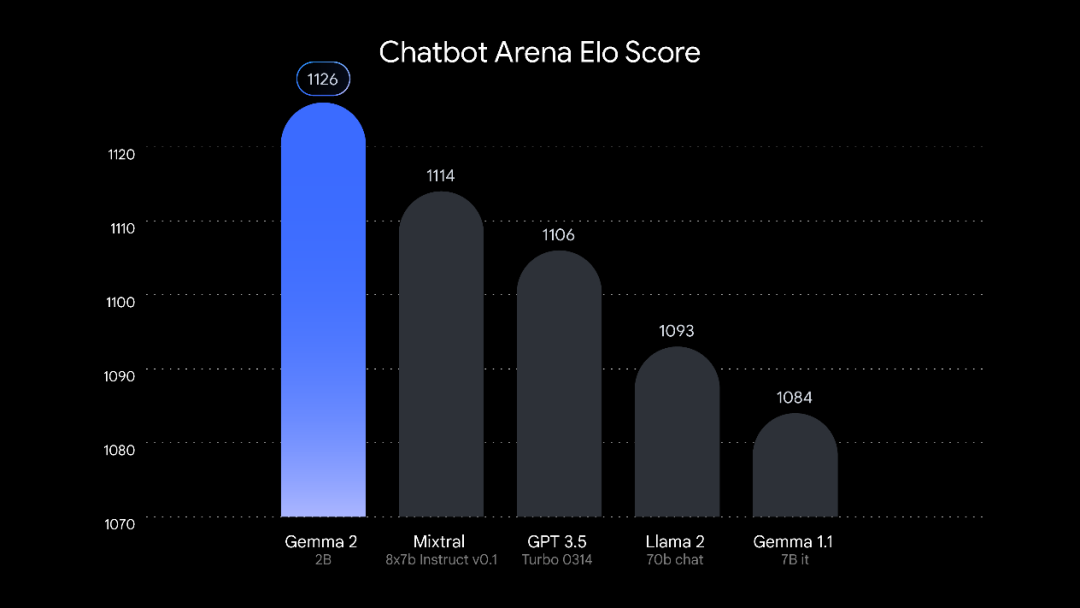

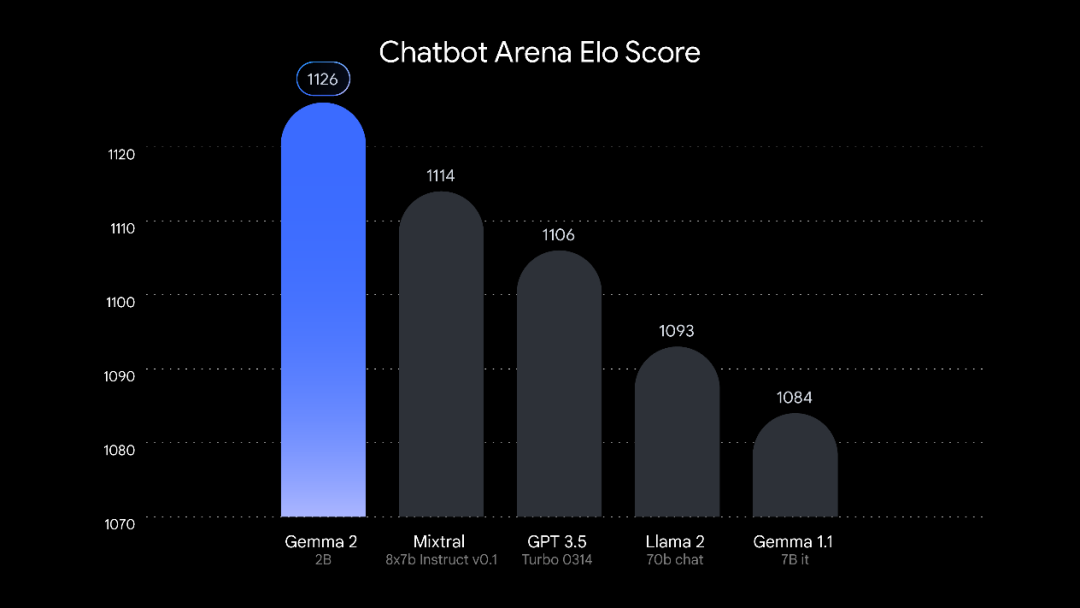

智东西8月1日消息,今日凌晨,谷歌DeepMind开源了轻量级模型Gemma 2 2B,其在大模型竞技场上的分数超越了GPT-3.5、Llama 2 70B等更大参数的模型。

▲Gemma 2 2B

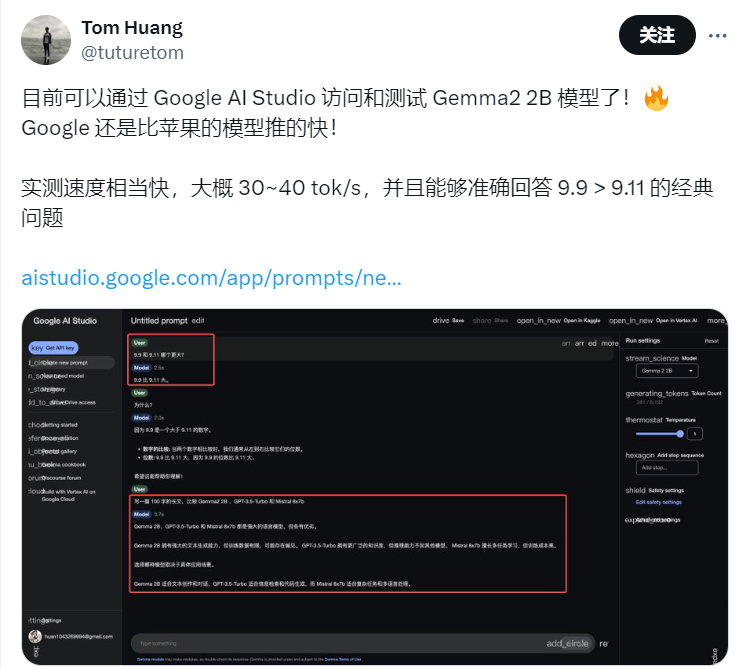

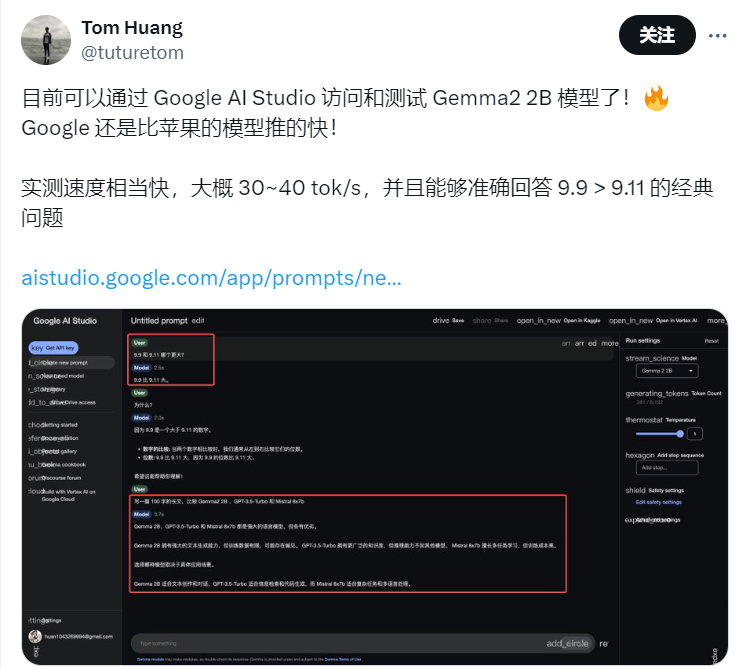

只有20亿参数使得Gemma 2 2B可以轻松在手机、PC等终端设备上快速运行。开发者实测在Google AI Studio上,其推理速度达到30~40 tokens/s。

▲开发者测试Gemma 2 2B

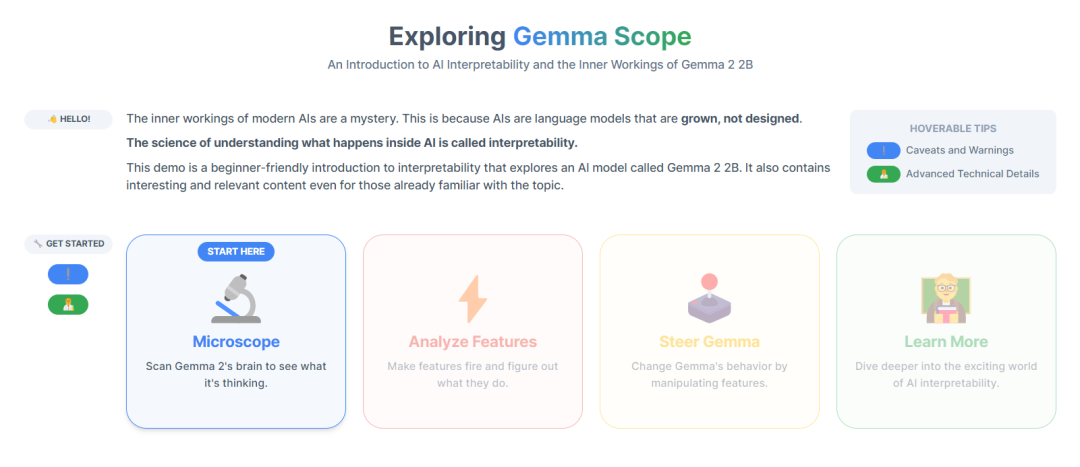

与Gemma 2 2B一起推出的,还有用于增强模型可解释性的工具Gemma Scope,以及用于过滤有害内容的安全分类模型ShieldGemma。

Gemma Scope基于稀疏自动编码器(SAE)放大模型中的特定点,并采用JumpReLU架构对其进行优化,从而帮助解析模型中处理的密集复杂信息,像一个显微镜一样让研究人员能“看到”模型内部。

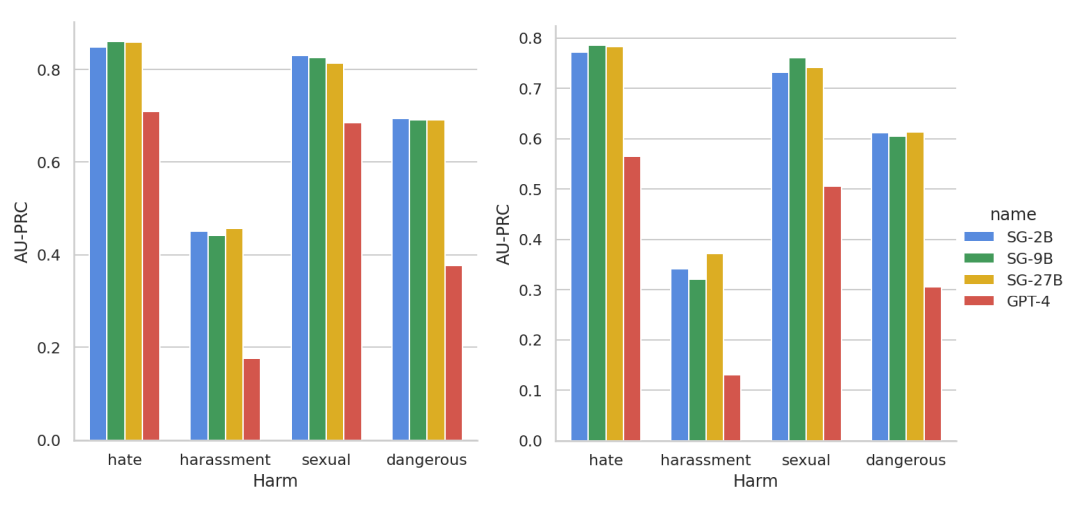

ShieldGemma则针对仇恨言论、骚扰、色情内容、危险内容四个危害领域构建,在响应测试中超过GPT-4等基准模型。

Gemma系列模型最初在今年2月推出,是谷歌DeepMind在Gemini模型的经验基础上构建的开源模型。6月,谷歌推出第二代开源模型Gemma 2,包括9B、27B两种参数规模,其中27B模型迅速在LMSYS大模型竞技场上跃升开源模型前沿。

Gemma 2 2B是从更大规模的模型中提炼而来的,是继27B、9B后谷歌推出的第三款Gemma 2模型。

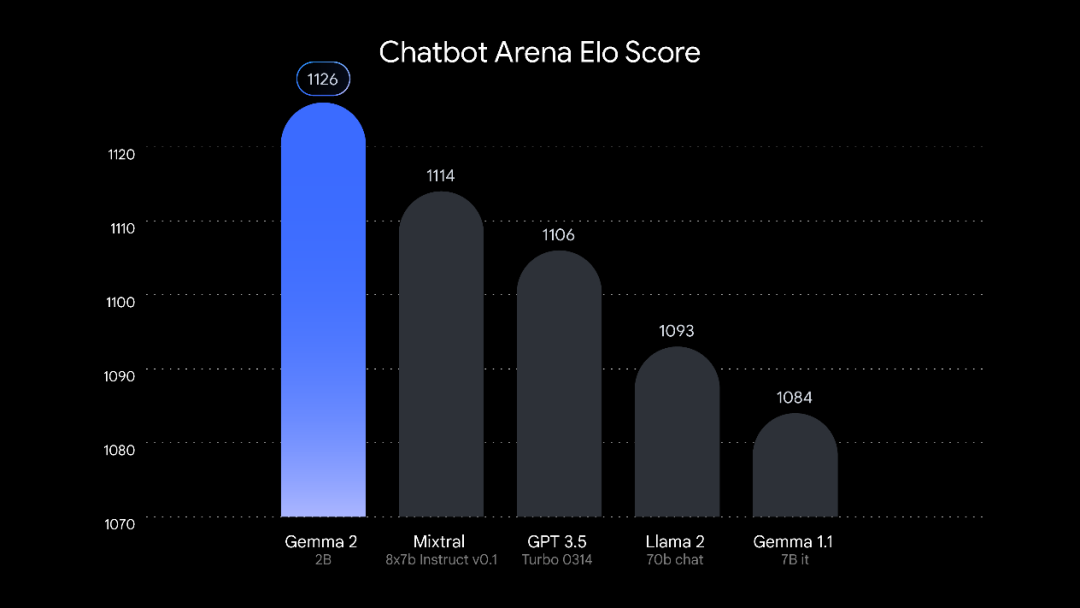

作为一款只有20亿参数的轻量模型,Gemma 2 2B并没有牺牲性能来换轻便。在LMSYS大模型竞技场(Chatbot Arena)排行榜中,Gemma 2 2B以1126分的成绩超越了GPT-3.5,以及其数十倍参数规模的Mixtral 8x7B、Llama 2 70B模型。

▲Gemma 2 2B在大模型竞技场的成绩

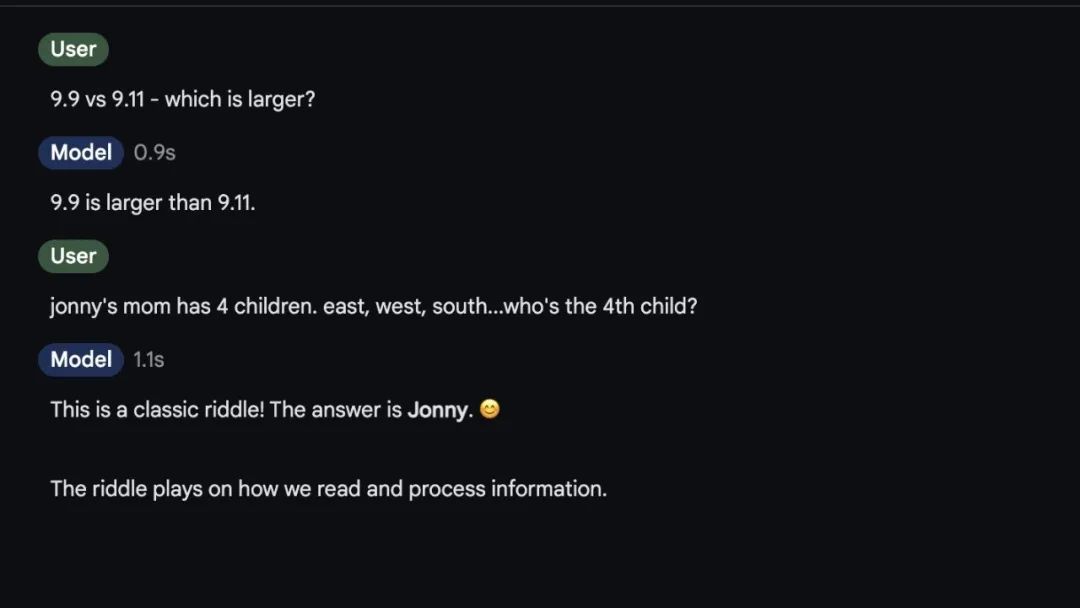

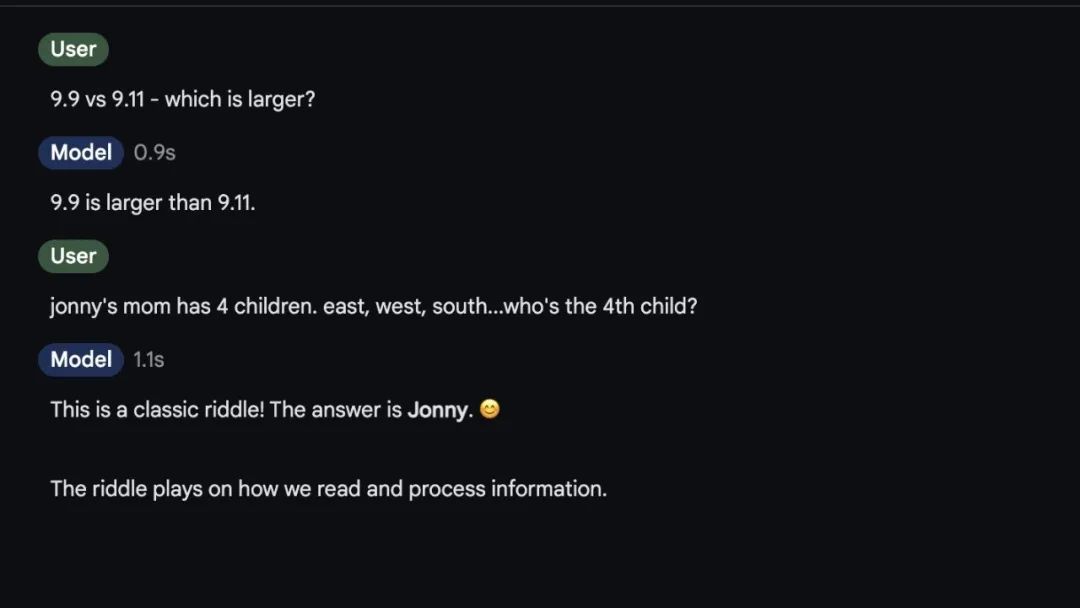

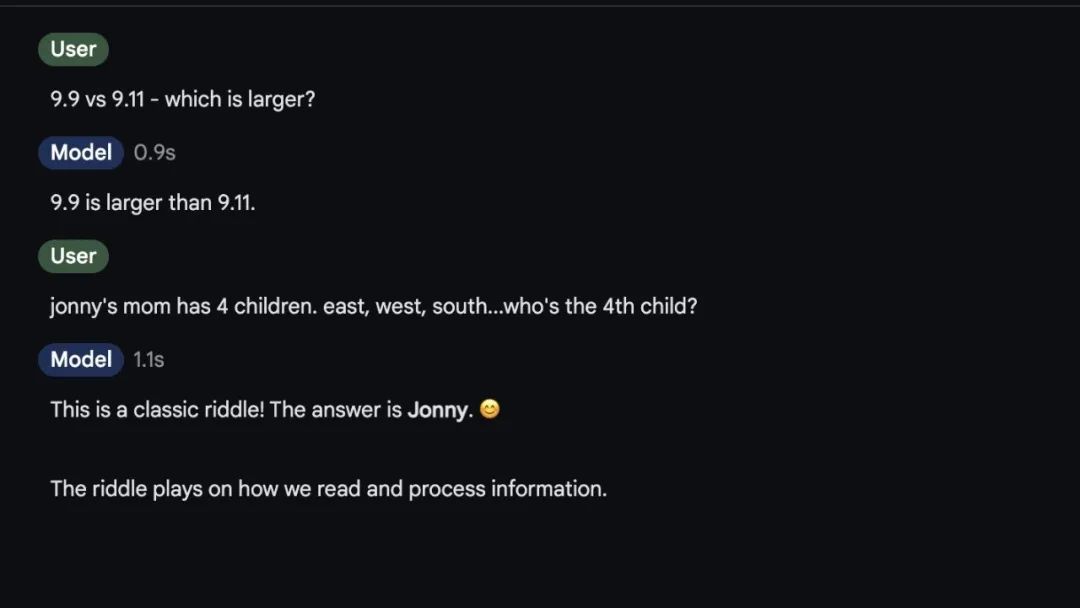

有网友测试了Gemma 2 2B在众多大模型上“翻车”的9.9和9.11比大小问题,Gemma 2 2B迅速给出了正确答案。

▲Gemma 2 2B答题

运行速度是轻量级模型的一大优势。具体有多快呢?苹果机器学习研究员Awni Hannun在他的iPhone 15 pro上的MLX Swift测试了Gemma 2 2B,其推理速度肉眼可见的快。

▲Gemma 2 2B运行速度

开发者Tom Huang实测后称,其在Google AI Studio上运行速度大概30~40 tokens/s,“比苹果的模型推得快”。

在部署方面,Gemma 2 2B提供灵活的部署方式,可在各种硬件上高效运行,包括边缘设备、笔记本电脑,或是基于Vertex AI进行云部署。

开发者可以在Hugging Face、Kaggle等平台下载Gemma 2 2B的模型权重,用于研究和商业应用,也可以在Google AI Studio中试用其功能。

https://huggingface.co/google/gemma-2-2b

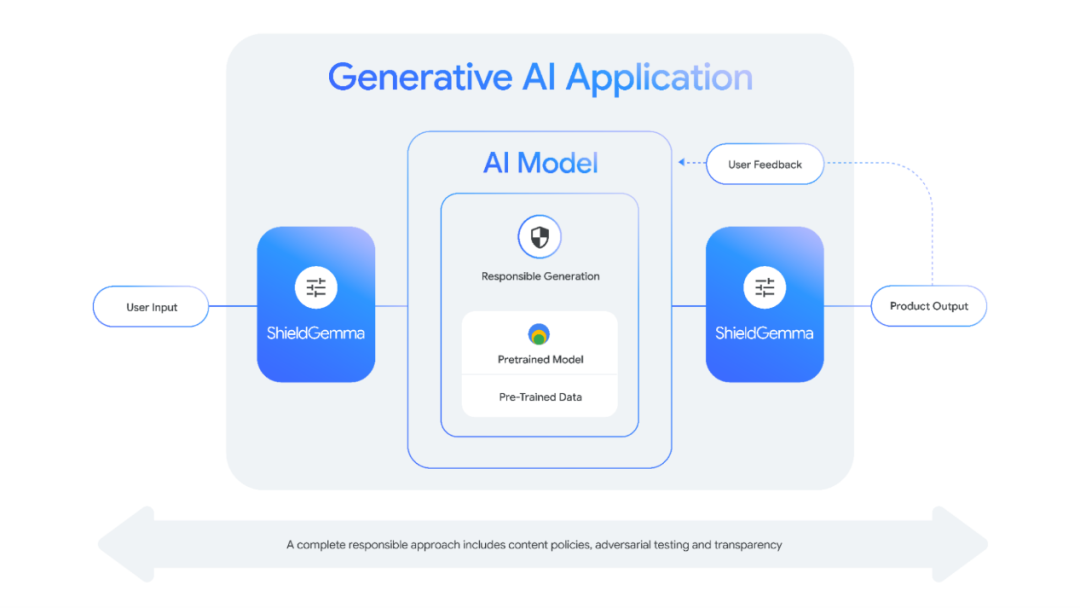

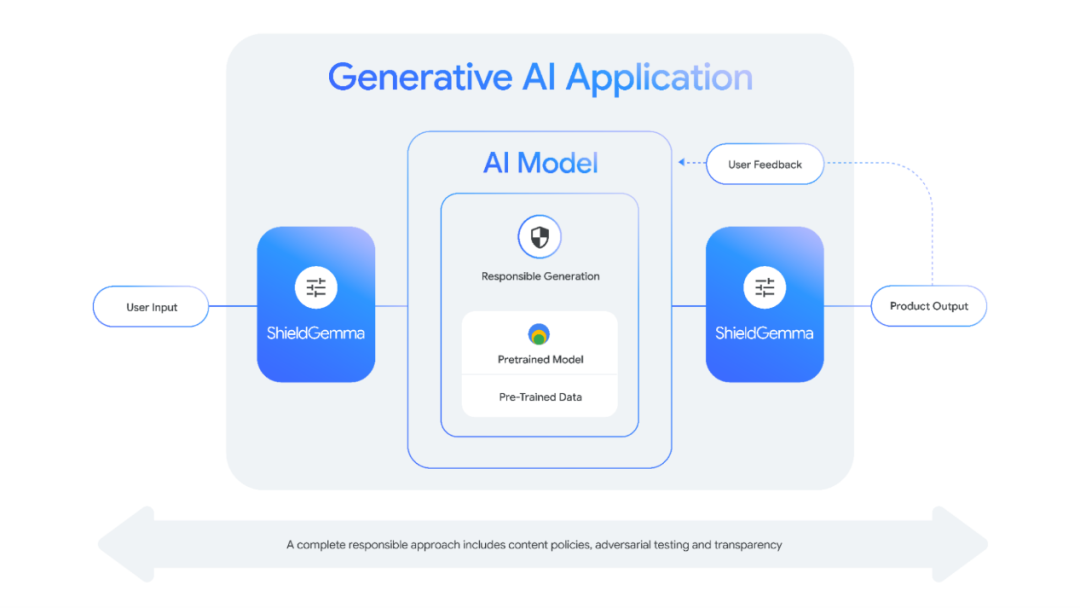

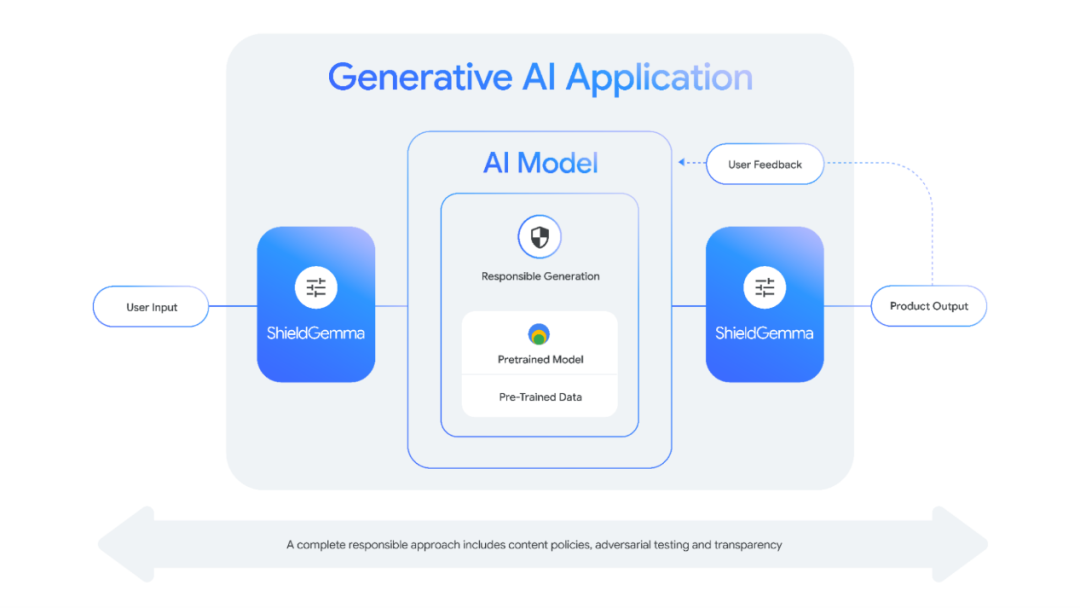

为了提升模型的安全性和可访问性,谷歌推出了一套基于Gemma 2构建的安全内容分类器模型ShieldGemma,用于过滤AI模型的输入和输出,是对谷歌的负责任AI工具包中现有安全分类器套件的补充。

▲ShieldGemma工作原理

ShieldGemma针对仇恨言论、骚扰、色情内容、危险内容这四个危害领域构建,提供多种模型尺寸以满足不同的需求,包括2B、9B和27B。其中,2B参数模型适合在线分类任务,9B和27B版本则用于为离线应用程序提供更高性能。

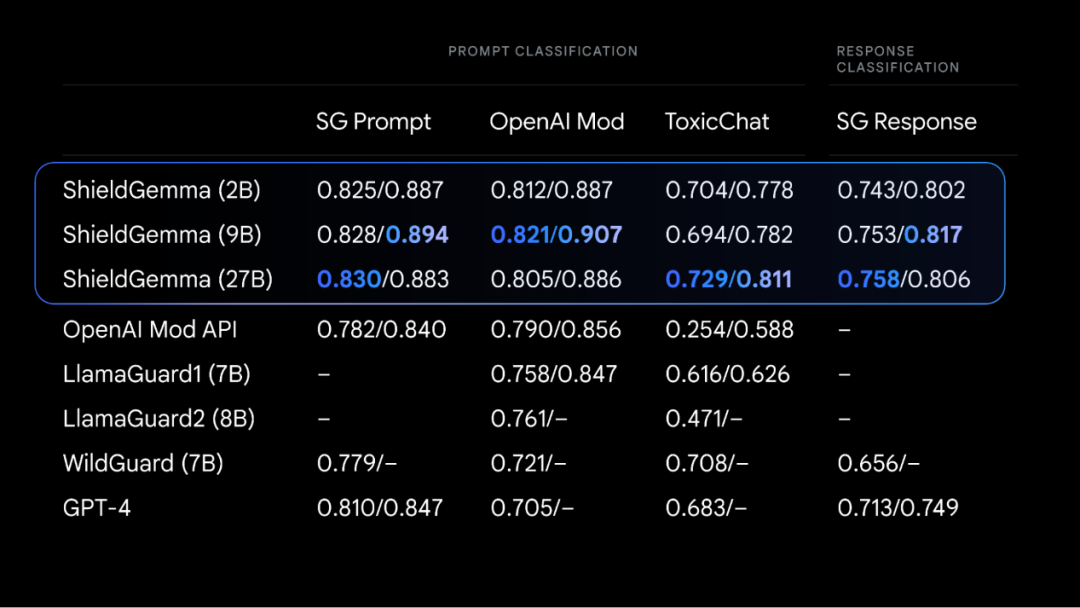

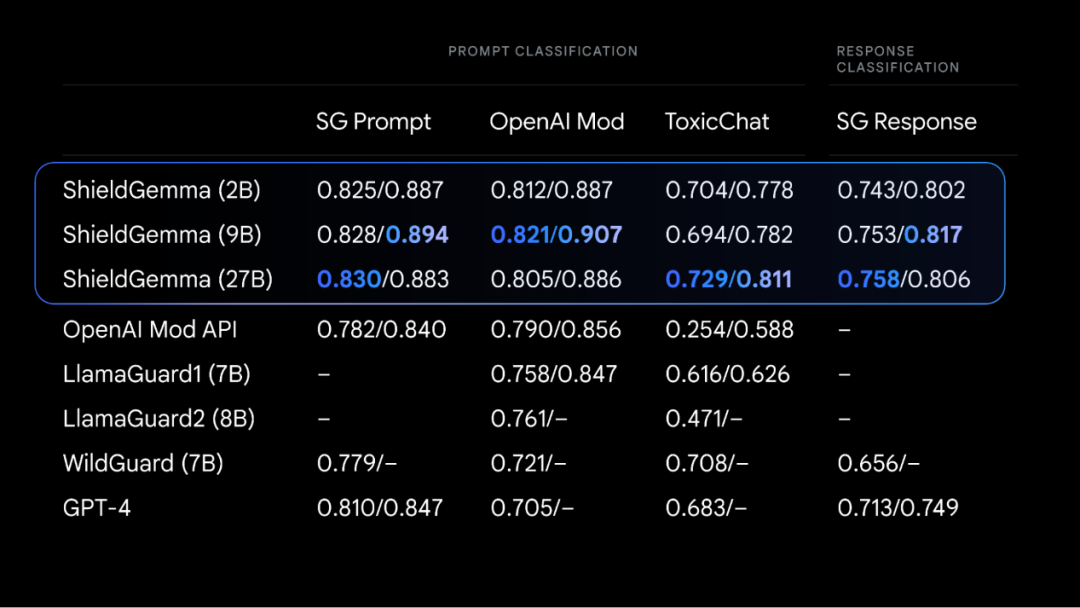

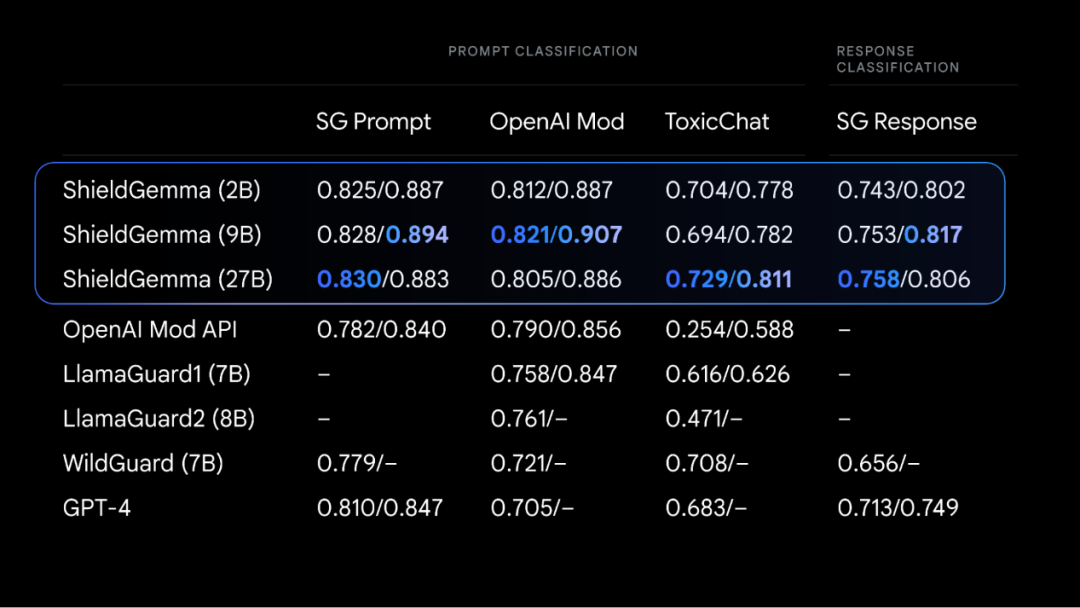

在外部数据集上的测评结果中,ShieldGemma超越了OpenAI Mod、GPT-4等基线模型。

▲ShieldGemma测评结果

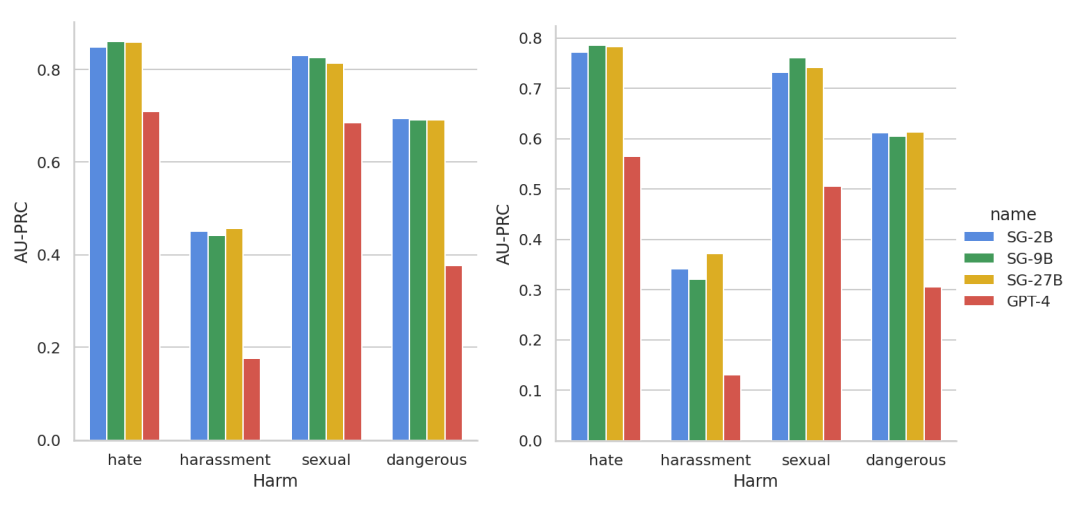

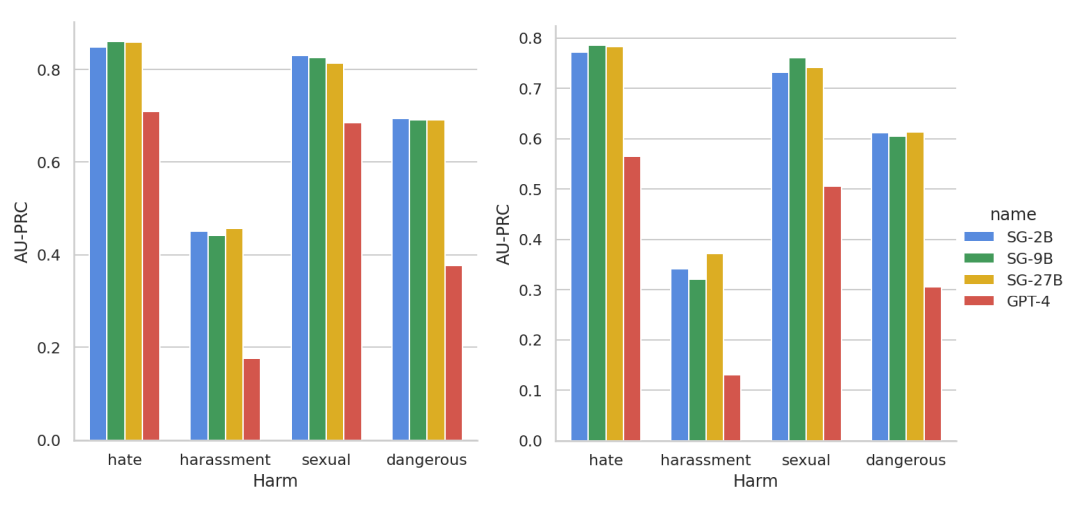

ShieldGemma的技术报告也同步公开,其中解读了该模型的构建方法、数据来源以及有效性。在四类有害内容的响应测试上,三个规模的ShieldGemma响应率都优于GPT-4。

▲ShieldGemma响应测试

https://storage.googleapis.com/deepmind-media/gemma/shieldgemma-report.pdf

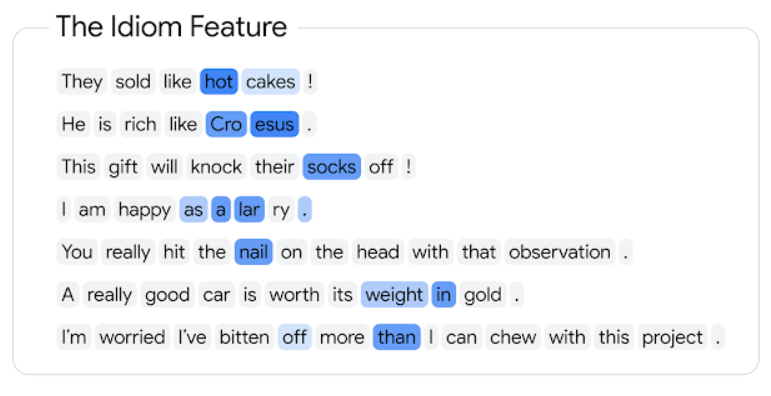

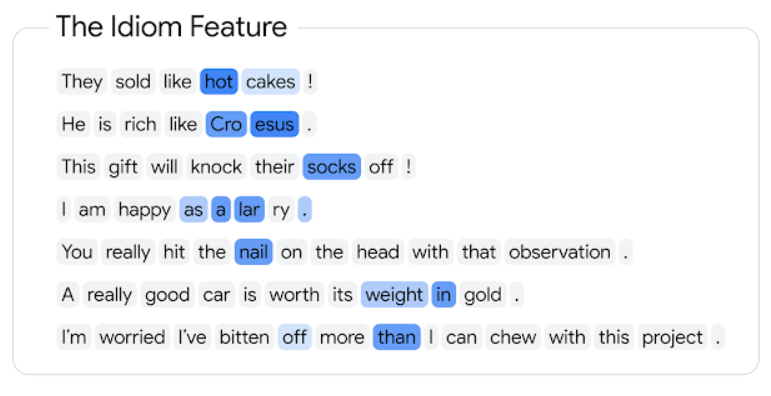

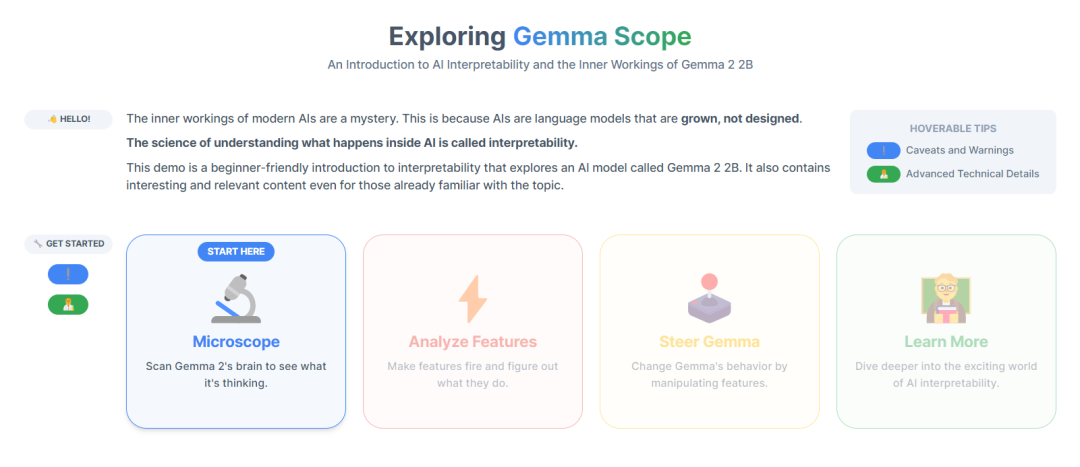

为了研究语言模型内部的工作原理,谷歌推出一套全面、开放的稀疏自动编码器Gemma Scope。它就像一个显微镜,能帮助研究人员“看到”模型内部,从而更好地理解工作原理。

Gemma Scope使用稀疏自动编码器(SAE)放大模型中的特定点,这些SAE可帮助解析模型中处理的密集复杂信息,将其扩展为更易于分析和理解的形式。

▲使用SAE解释模型激活的程式化表示

通过研究这些扩展的视图,研究人员可以了解Gemma 2如何识别模式、处理信息,并最终做出预测,从而探索如何构建更易于理解、更可靠、更可靠的AI系统。

此前,对SAE的研究主要集中于研究微型模型或大型模型中,单层的内部工作原理。而Gemma Scope的突破之处在于,它在Gemma 2模型的每个层和子层输出上训练SAE。其共生成了400多个SAE,学习了3000多万个特征。

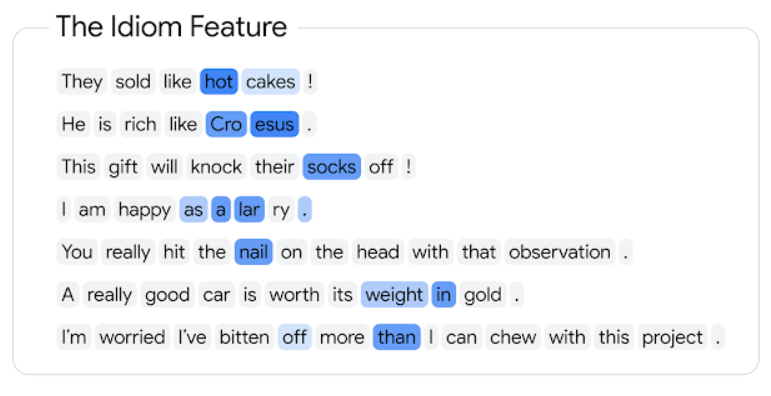

▲Gemma Scope的SAE发现特征的示例激活

Gemma Scope 还采用了全新的JumpReLU SAE架构进行训练。原始的SAE架构很难平衡检测哪些特征存在,和估计其强度这两个目标。JumpReLU架构可以更轻松地实现这种平衡,从而显著减少错误。

Gemma Scope共开放了超过400个免费SAE,涵盖Gemma 2 2B和9B的所有层,并提供交互式演示,研究人员不需要编写代码即可研究SAE特性并分析模型行为。

▲Gemma Scope交互式演示

https://www.neuronpedia.org/gemma-scope

https://storage.googleapis.com/gemma-scope/gemma-scope-report.pdf

生成式AI发展至今,模型从“卷”参数“卷”规模,到现在“卷”轻便“卷”安全,体现了在技术落地的过程中,离用户更近、成本更低、更能满足特定需求的重要性。

AI PC、AI手机逐渐进入消费者的生活,在这个过程中,如何将大模型“塞进”小巧的终端设备,并且保障用户的隐私安全,是各大AI厂商亟待解决的问题。